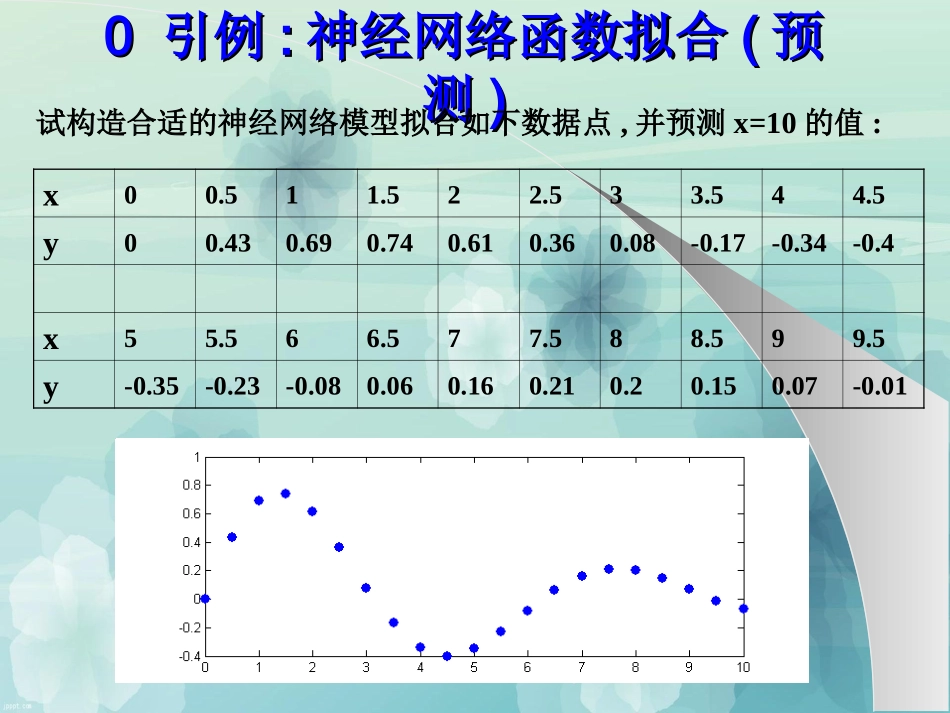

模式识别讲义第5章人工神经网络xxx嘉应学院—matlab神经网络工具箱主要内容主要内容0引例:神经网络函数拟合(预测)1matlab神经网络工具箱2人工神经网络(ANN)简介3前馈神经网络(BP网络)4实例:多元神经网络预测5实验:神经网络分类00引例引例::神经网络函数拟合神经网络函数拟合((预预测测))试构造合适的神经网络模型拟合如下数据点,并预测x=10的值:x00.511.522.533.544.5y00.430.690.740.610.360.08-0.17-0.34-0.4x55.566.577.588.599.5y-0.35-0.23-0.080.060.160.210.20.150.07-0.01matlabmatlab代码代码x=0:0.5:9.5;y=[0,0.43,0.69,0.74,0.61,0.36,0.08,-0.17,-0.34,-0.4,-0.35,-0.23,-0.08,0.06,0.16,0.21,0.2,0.15,0.07];net=newff([0,9.5],[5,1]);net.trainParam.epochs=100;net.trainParam.goad=0.000001;net=train(net,x,y);x1=0:0.1:10;y1=sim(net,x1);figure;plot(x,y,'.');holdon;plot(x1,y1,'r');∑f∑f∑f∑f∑f∑fxyw11w12w13w14w15w21w22w23w24w25b1b2b3b4b5b网络结构网络结构221()1xxefxey=f(w21*f(w11*x+b1)+…+w25*f(w15*x+b5)+b)w1=net.IW{1};w2=net.LW{2};b1=net.b{1};b2=net.b{2};a=tansig(w1*x0+b1);y=tansig(w2*a+b2)Sigmoid函数1matlab1matlab神经网络工具箱神经网络工具箱1.11.1网络数据对象的建立网络数据对象的建立net=newff([xm,xM],[h1,…,hk],{f1,…,fk});xm,xM分别为列向量(行数为变量个数),分别存储每个变量的最小值和最大值。[h1,…,hk]表示网络各层的节点数,一共有k层.{f1,…,fk}表示各层使用的传输函数,默认为’tansig’,即Sigmoid函数。还可使用函数’purelin’,即f(x)=x。其它可看matlab帮助:helpnewff1.21.2网络数据对象网络数据对象netnet的属性的属性net.IW:来自输入层的加权矩阵。BP网络只用net.IW{1},表示各个输入变量对第1层各节点的加权矩阵。net.LW:来自中间层的加权向量。BP网络用net.IW{2,1}表示第1隐层个节点向下一层个节点的加权矩阵;net.IW{3,2}表示第2隐层向下一层的加权矩阵…net.b:各层的偏移。Net.b{1}表示第1隐层个节点的偏移…net.trainParam.epochs:最大训练步数。不过当误差准则满足时,即使没达到此步数也停止训练。缺省为100。net.trainParam.goad:网络误差准则,当误差小于此准则时停止训练,缺省为0。net.trainFcn:训练算法。缺省为’trainlm’,即Levenberg-Marquardt算法。还可使用‘traingdx’,即带动量的梯度下降算法;’traincgf’,即共轭梯度法。其它可看matlab帮助:help->contents->NeuralNetworkToobox->NetworkObjectReference;help(net.trainFcn)helpnewffCaution:trainlmisthedefaulttrainingfunctionbecauseitisveryfast,butitrequiresalotofmemorytorun.Ifyougetan"out-of-memory"errorwhentrainingtrydoingoneofthese:–Slowtrainlmtraining,butreducememoryrequirementsbysettingnet.trainParam.mem_reducto2ormore.(Seehelptrainlm.)–Usetrainbfg,whichisslowerbutmorememory-efficientthantrainlm.–Usetrainrp,whichisslowerbutmorememory-efficientthantrainbfg.1.31.3网络的训练网络的训练[net,tr,Y1,E]=train(net,X,Y);net是函数newff建立的数据对象。X为n*m的矩阵,n为输入变量个数,m为样本数(即把每个样本是一个列向量)。Y为k*m的矩阵,k为数出变量个数。tr返回训练的跟踪信息,tr.epochs为训练步数,tr.perf为各步目标函数的值。Y1和E返回网络最终的输出和误差。训练结束后可以用plotperf(tr)来绘制目标值随着训练步数变化的曲线。1.41.4网络的泛化网络的泛化((预测预测))Y=sim(net,X);net是函数newff建立的数据对象。X为n*m的矩阵,n为输入变量个数,m为样本数(即把每个样本是一个行向量)。Y为k*m的矩阵,k为数出变量个数。22人工神经网络人工神经网络(ANN)(ANN)简介简介2.12.1人工神经网络人工神经网络(ANN)(ANN)的研究内容的研究内容(1)理论研究:ANN模型及其学习算法,试图从数学上描述ANN的动力学过程,建立相应的ANN模型,在该模型的基础上,对于给定的学习样本,找出一种能以较快...