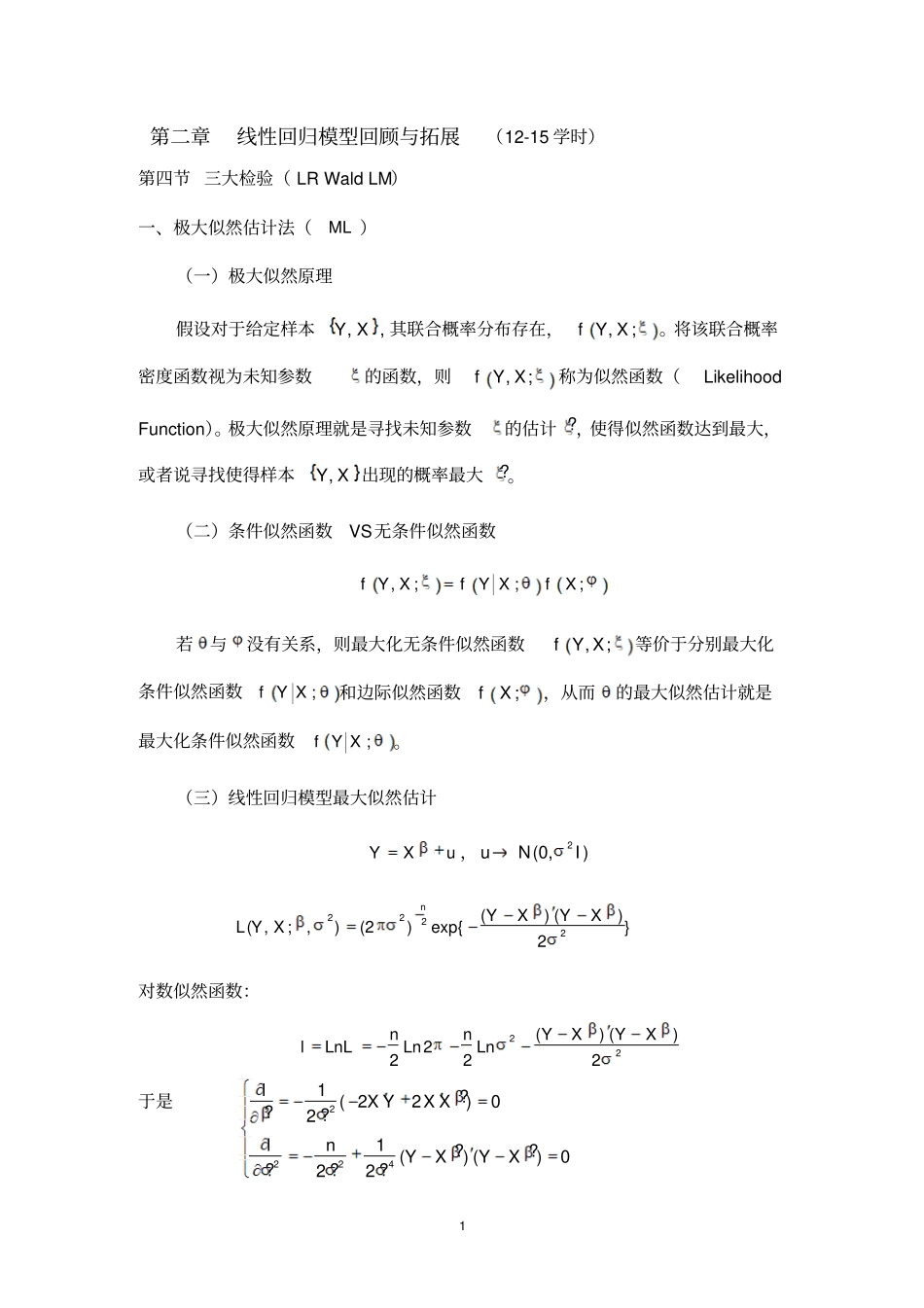

1 第二章线性回归模型回顾与拓展(12-15 学时)第四节 三大检验( LR Wald LM)一、极大似然估计法(ML )(一)极大似然原理假设对于给定样本,Y X , 其联合概率分布存在,,;f Y X。将该联合概率密度函数视为未知参数的函数,则,;f Y X称为似然函数(Likelihood Function)。极大似然原理就是寻找未知参数的估计 ?,使得似然函数达到最大,或者说寻找使得样本,Y X 出现的概率最大?。(二)条件似然函数VS无条件似然函数,;;;f Y XfY XfX若与没有关系,则最大化无条件似然函数,;f Y X等价于分别最大化条件似然函数;f Y X和边际似然函数;fX,从而的最大似然估计就是最大化条件似然函数;f Y X。(三)线性回归模型最大似然估计YXu ,2(0,)uNI2222() ()( ,;,)(2)exp{}2nYXYXL Y X对数似然函数:22() ()2222nnYXYXlLnLLnLn于是22241?( 22)0??21??() ()0???22lX YX XlnYXYX2 得到12?()1?MLMLX XX Ye en(三)得分( Score)和信息矩阵( Information Matrix )( ; ,)lfY X称为得分;12...kllll得分向量;(Gradient )海瑟矩阵( Hessian Matrix):2lH信息矩阵:三*、带约束条件的最小二乘估计(拉格朗日估计)在计量经济分析中, 通常是通过样本信息对未知参数进行估计。但有些时候可能会遇到非样本信息——对未知参数的约束限制(如生产函数中的规模报酬不变等)。在这种情况下,我们就可以采用拉格朗日估计法。对于线性模型( 1),若其参数具有某种线性等式约束:0H(6)其中 H 是 mk 矩阵( mk ,()rank Hm )。可视为除分量0 以外的1k矩阵。上式表明未知参数12,,,k 之间的某些线性关系的信息。现在的问题是寻求满足上式又使() ()YXYX达到最小的估计量0?H 。3 为此,构造拉格朗日函数。 (是1m的向量)() ()LYXYXH(7)于是??220?HHHLX YX XH(8)?0?HHLH(9)由( 8)可得11???()2HHX XH(10)(10)式的 ?是 OLS 的估计量。两边再左乘H ,并结合( 9)式有11???0()2HHHHH X XH所以,11??2[()]HH X XHH代入( 10)式,我们便得到估计量:111???()[()]HX XH H X XHH(11)这就是拉格朗日估计, 或称为带约束的最小二乘估计。 它既利用了样本信息,也利用了非样本信息。另外,?H 也是带约束的极大似然估计量(证明从略)。四、广义最小二乘估计(GLS )1、数理过程在实际经济问题的分析过程中,常常遇到古典假定中2 的不满足, 即随机扰动项存在异方差...