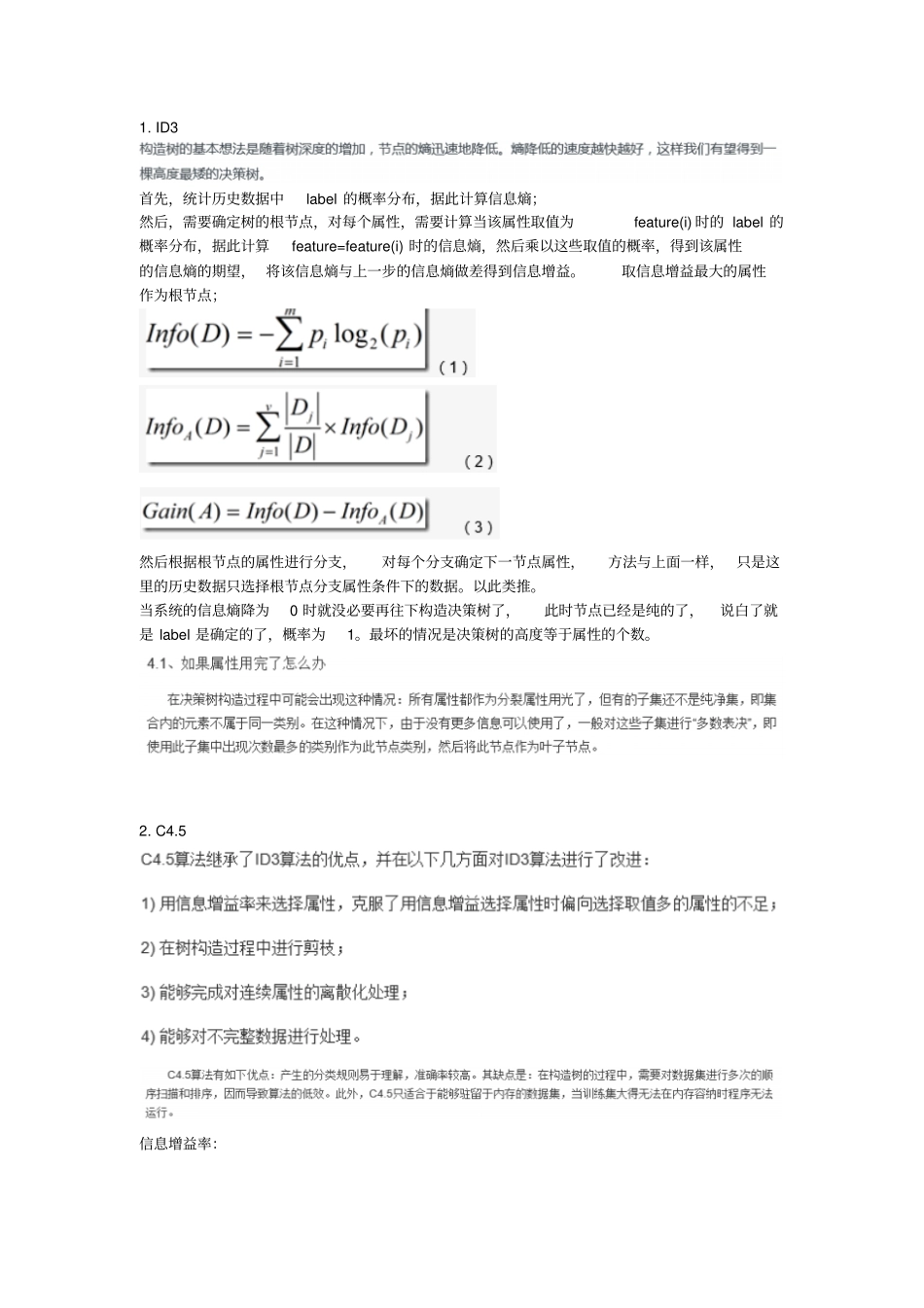

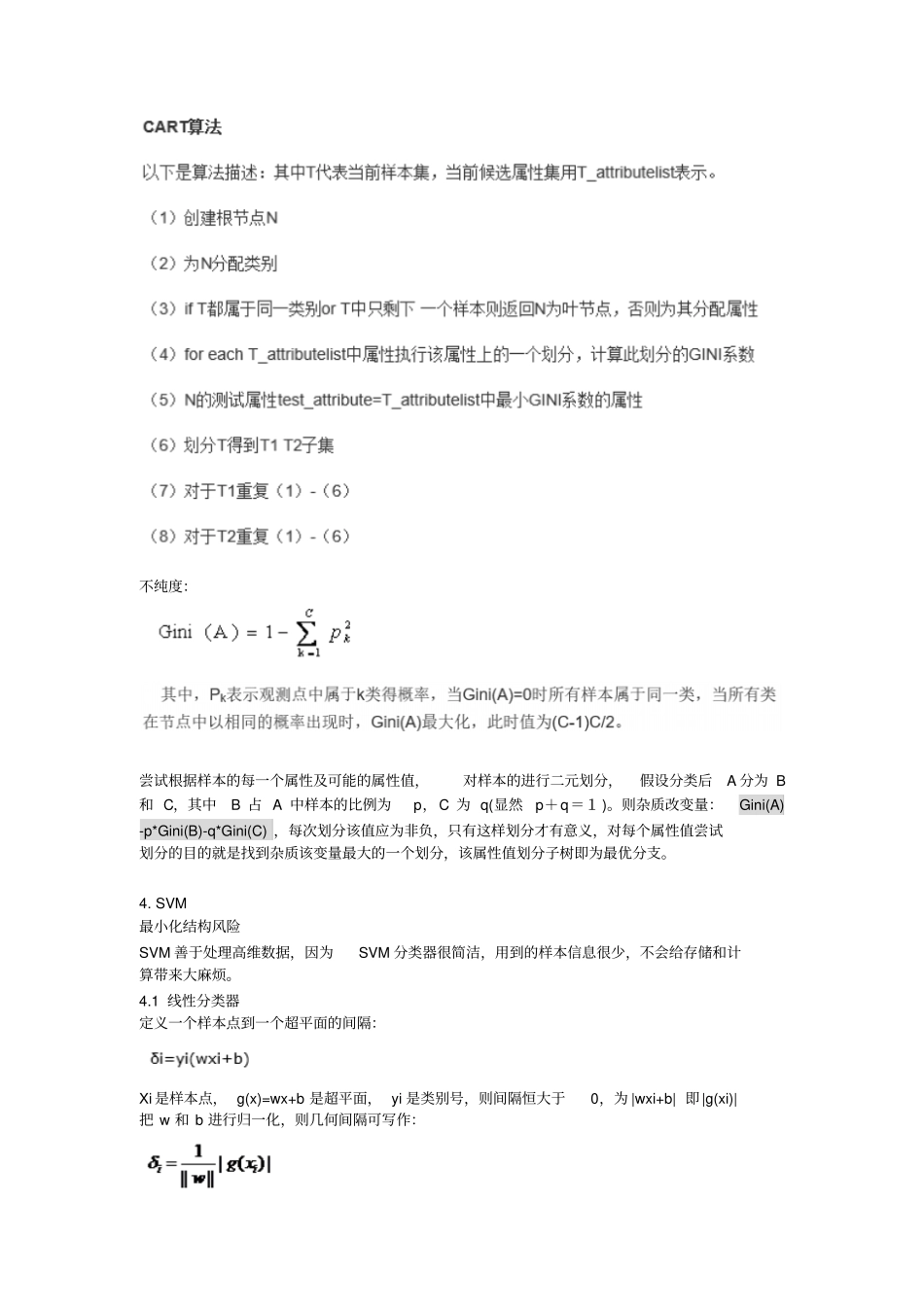

1. ID3 首先,统计历史数据中label 的概率分布,据此计算信息熵;然后,需要确定树的根节点,对每个属性,需要计算当该属性取值为feature(i) 时的 label 的概率分布,据此计算feature=feature(i) 时的信息熵,然后乘以这些取值的概率,得到该属性的信息熵的期望, 将该信息熵与上一步的信息熵做差得到信息增益。取信息增益最大的属性作为根节点;然后根据根节点的属性进行分支,对每个分支确定下一节点属性,方法与上面一样,只是这里的历史数据只选择根节点分支属性条件下的数据。以此类推。当系统的信息熵降为0 时就没必要再往下构造决策树了,此时节点已经是纯的了,说白了就是 label 是确定的了,概率为1。最坏的情况是决策树的高度等于属性的个数。2. C4.5 信息增益率:3. CART 不纯度:尝试根据样本的每一个属性及可能的属性值,对样本的进行二元划分,假设分类后A 分为 B和 C,其中B 占 A 中样本的比例为p,C 为 q(显然p+q=1 )。则杂质改变量:Gini(A) -p*Gini(B)-q*Gini(C) ,每次划分该值应为非负,只有这样划分才有意义,对每个属性值尝试划分的目的就是找到杂质该变量最大的一个划分,该属性值划分子树即为最优分支。4. SVM 最小化结构风险SVM 善于处理高维数据,因为SVM 分类器很简洁,用到的样本信息很少,不会给存储和计算带来大麻烦。4.1 线性分类器定义一个样本点到一个超平面的间隔:Xi 是样本点, g(x)=wx+b 是超平面, yi 是类别号,则间隔恒大于0,为 |wxi+b| 即|g(xi)| 把 w 和 b 进行归一化,则几何间隔可写作:最大化几何间隔和最小化||w||是一回事,我们通常固定间隔(如1)来寻求最大几何间隔,也就是最小化 ||w||,等价于最小化1/2||w||2。上面固定间隔为1,是把所有样本点中最近的两个点间隔固定为1,所以所有样本点间隔应满足约束:即所以分类问题最终转变为带不等式约束的最小值问题:w 是由样本确定的,因此w 可以写作:则原来的 g(x)可写作:把非向量拿出:最后变换得到:4.2 线性不可分情况核函数, 把低维线性不可分的输入转换为高维求内积的形式,所以把内积替换为核函数进行求解即可。首选径向基核函数。4.3 松弛变量和惩罚因子解决某些噪声点、离群点影响分类问题,加入松弛变量:优化问题变为:其中 C是惩罚因子5. EM(最大期望算法)在概率模型中寻找参数最大似然估计或者最大后验估计,其中概率模型依赖于无法观测的隐藏变量。(聚类)推导过程有...